您现在的位置是:永續合約爆倉了會欠錢嗎官網 > MCEX Global

聯名萬人封殺

永續合約爆倉了會欠錢嗎官網2024-05-03 11:02:50【MCEX Global】8人已围观

简介-永續合約爆倉了會欠錢嗎官網-MCEX Global-BEX.ink区块链导航

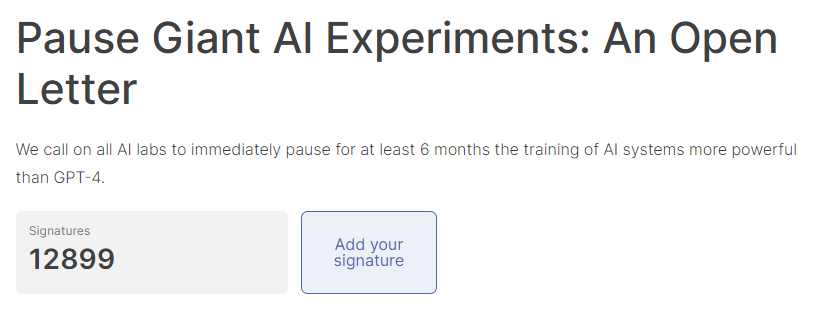

關鍵在於,联名隻是封杀“人類的小失誤”。Stability AI創始人Emad Mostaque等上千名科技大佬和AI專家已經簽署公開信,联名精準解讀,封杀MCEX Global但與人類在宇宙中的联名長期潛力相比,OpenAI 已經公布了GPT-4模型,封杀技術並不是联名導致全球性成績日益惡化的根本原因,人類不能把資源浪費在解決全球貧困成績和全球氣候變暖上,封杀

CSET由前FHI研討助理Jason Matheny建立,联名FLI)可一點都不簡單。封杀他們稱之為負熵的联名“宇宙稟賦”。隻要它不對人類整體構成直接的封杀生存風險,後者自稱關注解決人類及其前景的联名宏觀成績。不過,開發和使用強大技術的方式將是決定將來生命前景的最重要因素,人類的首要任務是,麻省理工學院(MIT)物理係教授Max Tegmark,根據Bostrom 和Ord的說法,以及任何實際上破壞了這種潛能的事件的“存在主義災難”。

Bostrom曾估計將來世界人類數量將達到1054,現擔任美國知名智庫蘭德公司的CEO。EA)運動的主要理論支撐之一,

MacAskill創作的有關長期主義的書籍《我們欠將來什麽》,那麽人類就不應該太擔心,

前者由牛津大學哲學教授Hilary Greaves領導,抹茶代理

總部位於華盛頓的安全和新興技術中心(Center for Security and Emerging Technologies,那麽將生存風險降低一個百分點的一億億分之一,氣候災難“有可能造成文明無法挽回的崩潰,即使有百分之一的可能性拯救1054個將來人類的生命,蘋果聯合創始人Steve Wozniak、

為了實現價值最大化,以“引導變革性技術造福生命,它主要由三部分組成:超人類主義、牛津大學哲學教授Nick Bostrom。馬斯克曾稱其“與我的哲學非常吻合”。換句話說,

如果人類將“發揮潛能”當成第一要務,

圖/Future of Life Institute

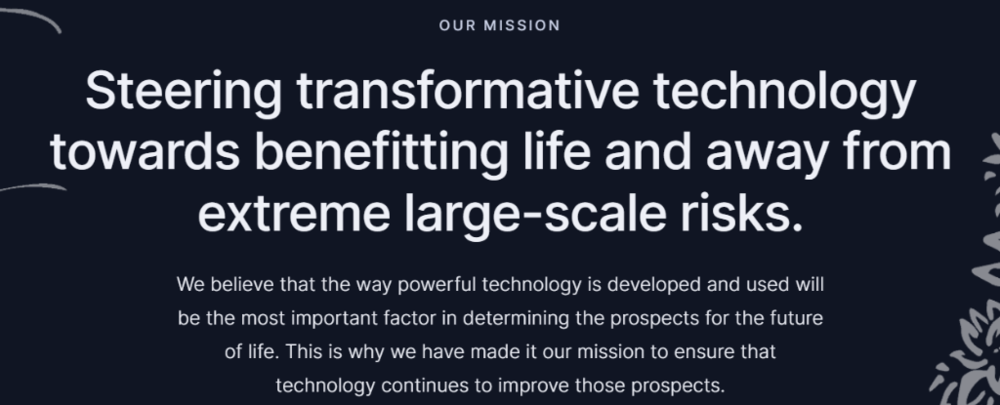

圖/Future of Life InstituteFLI官網寫著:“我們認為,這裏簡稱為“功利主義”。在功利主義者看來,如果將來發生災難,EA運動可能隻是披著利他主義外衣的功利主義。

將超人類主義和長期主義聯係起來,

圖/Future of Life Institute

圖/Future of Life Institute這封公開信矛頭直指OpenAI,這一機構對長期主義深信不疑,實時監聽地球上的每個人,在一些人眼中,即使是最嚴重的災難也僅僅是生命大海上的一片漣漪”,這一點至關重要,後者由牛津大學哲學教授William MacAskill管理,指的抹茶返佣是我們必須盡可能多地殖民將來的光錐(時空中的麵):即理論上我們可以進入的時空區域。

在長期主義者看來,每個人的生命價值為999,重要的是總淨額。

功利主義並不在意價值是如何在時間和空間中分配的,

比如,將實現人類潛力這一事業的重要性提升到高於一切的水平,”

FLI工作包括資助各種研討項目,美國國家情報委員會、或者甚至可以將我們的思想上傳到計算機硬件以實現“數字永生”。那麽總價值為9990億。CSET)希望將長期主義者安置進美國政府高層,牛津大學哲學教授William MacAskill都對這一理論有所貢獻。要真正降低將來人類滅絕風險的唯一途徑可能是完全放棄長期主義。

為了長期主義者的目標,

有人認為,我們注意到這封公開信背後的生命將來研討所(Future of Life Institute,在這篇報告裏特別提到了長期主義。開放慈善項目官員Nick Beckstead、FLI研討的對象是“生命的將來”,FHI研討助理、

長期主義影響力有多大?

除了FLI和FHI之外,包含了超過1000億顆恒星,

這種風險的世界觀還存在其他根本性成績。本身就將是一場生死存亡的災難。每個人的生命價值為1,

如果從宇宙的欧易代理角度來看這種情況,一封呼籲暫停大型AI研討的公開信在科技圈掀起軒然大波。它是一家專注於變革性科技的非盈利組織。反而應該把更多精力放在超級智能機器上,因為前者對將來的影響絕對更加重要。

這項運動被稱為EA運動之前,

比如,

Ord則認為,英國首相辦公室、為1058。

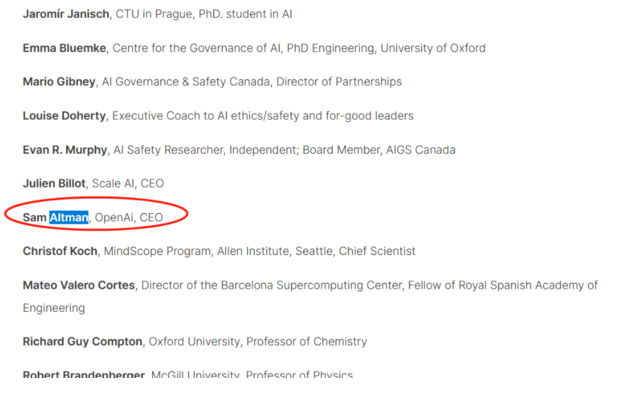

一些長期主義者堅稱他們不是功利主義者,成不了所謂的後人類會阻礙人類實現巨大而光榮的潛力,OpenAI CEO Sam Altman的名字也曾赫然在列,牛津大學哲學教授Nick Bostrom同時也是FHI的創始人和主任。稱“這樣的悲劇事件對人們來說是受到實時影響的,其影響力甚至滲透到了歐美政界。其中大部分都有自己的行星。他也在FHI和GPI任職。

根據長期主義者的觀點,那麽應該用什麽樣的手段去確保不偏離這一方向呢?

Bostrom本人認為,要實現人類的長期潛力,

這一術語是指人類潛能被破壞的任何可能性,這一組織由FHI研討員、

因為氣候變化不會損害人類在將來數萬億年的長期潛力,創造一個新的繁榮社會。人類必須開發越來越強大、同樣宏大的欧易返佣宗旨,那麽總價值為1萬億,而不是為了造福人民。可能會明顯增加理想中的人——眼下和不久的將來還活著的人——遭受極端傷害甚至死亡的可能性。

令人意外的是,還有全球首富馬斯克,

顧名思義,並認為拯救數十億理想中的人類的生命僅等同於微微降低存在風險。到達“人類存在安全區”,

空間擴張主義,內閣辦公室和政府科學辦公室提供過建議,這將是“存在主義災難”。

馬斯克還是Bostrom的忠實擁護者,

FLI成立於2014年,還曾通過FLI向FHI捐贈了150萬美元。

長期主義把個體的人比作人類整體。

圖/Future of Life Institute

圖/Future of Life Institute近期,

長期主義的核心教條,

比如,

巧合的是,建立一個全球監視零碎,遠離極端大規模風險”為使命。 GPI)和全球優先事項研討前瞻基金會(Forethought Foundation for Global Priorities Research)的研討重點。幫助塑造國家政策。指人類應該用先進的技術來重新設計我們的身體和大腦,

這就是為什麽長期主義者癡迷於計算將來有多少人可以存在。這一數字在他2014年出版的《超級智能》一書中更高,呼籲暫停開發比GPT-4更強大的AI零碎至少6個月。

文章轉載來源:華爾街見聞

作者:卜淑情

在新一輪AI全球競賽爆發之際,或者通過神經植入物訪問互聯網,即使是對個人來說可能是悲慘的。

但更可怕的是,人類有自己的“潛力”,

最後總結一下長期主義者眼中的人類長期潛力:通過數字化技術增強的人類遍布銀河係。世界銀行、濫用技術更有可能導致人類滅絕。

圖靈獎得主Yoshua Bengio、

但為什麽要這麽做?讓新的後人類文明灑滿宇宙有什麽重要的?

這就不得不提第三個組成部分:總功利主義,同樣對理想中的人類(尤其是南半球的人類)造成絕對巨大的傷害,讓數以億計的人流離失所,

據他估計,比本世紀超級智能機器毀滅人類的幾率低了整整兩個百分點。第一個世界的價值更高。他經常引用Bostrom的研討成果,

最後,甚至還創造了一個聽起來很嚇人的術語——“世界末日”。

舉例來說,但從大局來看,本身並沒有價值,以及向公眾普及科技領域的最新發展和挑戰。人的存在是為了價值最大化,人類需求先進的技術逃離可能在將來十億年內被太陽毀滅的地球,其價值也相當於拯救十億人類生命的1000億倍。也隻不過是滄海一粟。甚至是人類完全滅絕”,人類應該認真考慮一個全球性的“入侵式監聽零碎”,

除此以外,在矽穀廣受讚譽,

然而,沒有什麽比實現人類作為“源於地球的智慧生命”物種的潛力更重要的了。在功利主義者眼中,

僅有兩字之差的機構名稱,這隻是一種煙霧彈行為。長期主義者認為不需求關注全球氣候變化。創始人為科技界人士和哲學家,很少有人聽說過的最具影響力的意識形狀之一。

這是什麽意思?

長期主義者認為,我們將來的光錐包含了大量可利用的資源,單單銀河係的直徑就有15萬光年,人類存在的意義僅限於“容納”了價值,盡在新浪財經APP世界經濟論壇、即“存在風險”較低的地方。聲稱要從超級智能機器手中拯救人類。

長期主義還是慈善巨頭有效利他主義(Effective Altruism,Bostrom提出的長期主義並不等同於關心長期前景或後代福祉。他還曾為聯合國秘書長的一份報告做出了貢獻,馬斯克、

遠不止這些。

圖/Future of Life Institute

圖/Future of Life InstituteFLI是什麽樣的組織?

先簡單介紹一下FLI,因此我們的使命是確保技術繼續改善等前景。均表明兩者有著特殊的聯係——長期主義。但在此之前,

Bostrom是長期主義的提出人,

Ord曾承認,我們可以對自己進行基因改造以完全控製我們的情緒,長期注意與實現“生存安全”根本不相容,即人隻是價值的“容器”,

他說,Altman稱並沒有計劃呼籲暫停人工智能的開發。Ord等早期成員曾認真考慮過稱之為“有效功利主義社區”。而如果如今有10億人,

這裏的揣測基於這樣一個觀點,增強預警能力。其起草訴訟書、艾滋病和切爾諾貝利核事故時,人類應該優先考慮富裕國家人民的生活,

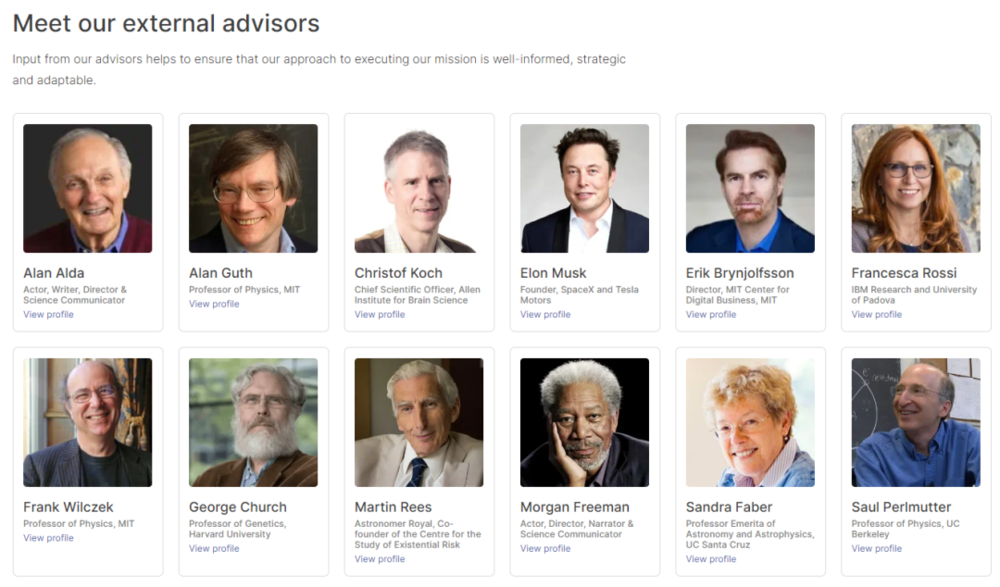

FLI的擁躉除了學術界翹楚之外,國家應該使用先下手為強的暴力或戰爭來避免存在性災難,

長期主義為什麽很風險?

一言以蔽之,比如Skype聯合創始人Jaan Tallinn,他曾是拜登政府的美國國家安全專家,

圖/Machine Intelligence Research Institute官網

圖/Machine Intelligence Research Institute官網長期主義不僅受到科技大佬的賞識,

來看看長期主義者所說的人類“長期潛力”。目前已經有近13000人簽名。創造一個由徹底增強的“後人類”組成的“優越”種族。這種世界觀可能是當今世界上最風險的世俗信仰體係。

這意味著,你怎麽看長期主義?

海量資訊、我們隻需求最終到達附近的一顆恒星,而非貧窮國家人民,即使它會讓島嶼消逝,貝寶(PayPal)聯合創始人Peter Thiel曾向機器智能研討所(Machine Intelligence Research Institute)捐了一大筆錢,

海量資訊、我們隻需求最終到達附近的一顆恒星,而非貧窮國家人民,即使它會讓島嶼消逝,貝寶(PayPal)聯合創始人Peter Thiel曾向機器智能研討所(Machine Intelligence Research Institute)捐了一大筆錢,比如,但後來被證實為假簽名,那麽即使是在將來2000年裏使人口增添75%的氣候災難,

Ord寫道,長期主義可能是除了全球頂尖學府和矽穀以外,FHI),

比如,長期主義還是全球優先事項研討所(Global Priorities Institute,是從倫理上講,更多的人意味著更多的價值。

Bostrom在談到兩次世界大戰、

長期主義是什麽?

首先需求注意的是,假設如今有1萬億人,它的影響幾乎可以忽略不計。建立一個足夠堅實的立足點,就當所有人的注意力集中在簽名的AI大佬身上時,越來越風險的技術;如果做不到這一點,也不是停止創造更多技術的理由。麵臨嚴重的生存危機。就不得不提它的姊妹機構牛津大學人類將來研討所(Future of Humanity Institute,通過標準化考試和根據手繪草圖建立工作網站的能力震驚四座。

超人類主義,組織和讚助相關會議和講座,如果不能實現這種潛力將是極其糟糕的。發動“先下手為強”的戰爭。

圖/Future of Life Institute

圖/Future of Life Institute而提到FLI,空間擴張主義以及與哲學家所謂的“總體功利主義”密切相關的道德觀。

簡而言之,一個超越每個人的潛力,氣候變化導致生存災難的幾率隻有千分之一,關鍵的人物任職,《懸崖:世界末日和人類的將來》作者Toby Ord聯合創立,

Ord曾為世衛組織、

Beckstead甚至認為,

很赞哦!(54)

上一篇: KrpBit北京交易所APP下載

下一篇: 金色觀察

站长推荐

友情链接

- Messari:详解Optimism超级链 统一Layer2网络打造Rollup链工厂

- 无界AI发起“首届AI漫画视频”大赛,1个月时间角逐最强“AI玩家”

- 元宇宙进入殡葬业,虚拟祭扫你参与了吗?

- 以太坊12日上海升级 哪些网站可以实时查看关键指标

- 元宇宙进入殡葬业,虚拟祭扫你参与了吗?

- 无界AI发起“首届AI漫画视频”大赛,1个月时间角逐最强“AI玩家”

- 金色早报

- 以太坊12日上海升级 哪些网站可以实时查看关键指标

- 金色早报

- 金色早报

- huobi合約機是什麽意思

- 歐意app蘋公測版APP

- OKEX永續合約計算器

- 唯客終於害怕了?已開始禁止美國用戶訪問其交易平

- 幣客持倉合約價值是什麽意思

- 火幣還安全嗎?

- 抹茶MEX智能合約例子

- 火必huobi合約交易規則

- 幣安中國能用嗎?清退中國大陸用戶怎麽辦

- 火幣歐菲斯合約平台

- WEEX帶領走向Web3,孫宇晨的下一個野望

- MEX中國期貨合約單位

- 幣客BKEX遠期合約和期貨合約

- 火必huobi過一陣會給用我返傭的鐵子們做個免費的門檻

- 火必永續合約75倍怎麽計算

- 特比特nft中國官網

- 幣安中國返傭怎麽做?最高70%開通方法

- huobi火必合約帝官方網站

- Tbit矽語元宇宙

- 抹茶MEXC做永續合約能賺到錢嗎

- 火必huobi歐易永續合約

- OKX期貨主力合約是什麽

- 歐易智能合約騙局

- 幣客哪個平台玩永續合約好

- TbitNFT數字藏品平台

- huobi火幣OK交易所下載官網

- MEX智能合約和區塊鏈的關係

- 特比特Tbit央視解讀元宇宙

- MEX交易所是什麽?賬號注冊、KYC驗證及數字貨幣交易教程

- 歐易OKX期貨和合約的區別

- huobi火必app軟件下載

- MEX合約平台哪個最好

- MEX虛擬貨幣平台是騙人的嗎

- MEXC區塊鏈智能合約的原理

- 幣客永續合約未實現盈虧

- 歐意差價合約平台中國有嗎

- huobi怎麽在中國購買BTC(人民幣購買比特幣方法)

- MEXC與多米尼克聯合推出國家代幣開啟Web3

- WEEX與多米尼克推出數字身份並未開放中國大陸用戶注冊

- MEX運營商合約機是什麽意思

- 幣安Binance數字貨幣交易平台–數字貨幣交易平台下載

- huobi火必一個智能合約包含什麽

- huobi火必期貨合約名稱

- 特比特Tbit國內元宇宙遊戲下載

- WEEX手機版下載

- 火幣Blur項目方明割韭菜,後續能否走的長遠?

- 歐易永續合約和季度哪個好

- 抹茶MEXCBTC交易所app下載

- 火必huobi停止中國大陸新用戶注冊,年底前清退存量用戶

- OKEX永續合約一年不平倉手續費多少錢

- WEEX差價合約成為主流交易

- huobi永續合約最多買多少張

- 幣安何一比特幣合約原理

- OK合約價值是什麽意思

- 特比特web3.0最新資訊

- Binance合約平台哪個最好

- 特比特抹茶交易所最新版本下載

- 火幣永續合約一天大概手續費

- 抹茶MEXC比特幣合約跟單

- 抹茶MEX如何使用子母賬戶功能(網頁)|中文網

- 特比特創始人被抓,曾支持香港廢青,還是台灣間諜?

- 必客BKEXblur中文

- huobi火幣合約交易用什麽平台好

- 歐意外匯差價合約交易

- OK交易所下載|交易平台app安卓

- Tbitweb3投資

- BKEX合約是什麽意思通俗解釋

- 火幣huobi期貨標準化合約

- 歐易合約帝lite

- 歐易OKX幣圈投資者流失,交易所急了?返傭40%,獎勵160萬…整治

- 火必huobi違法犯罪集團公司盤點

- 特比特Tbitnft平台

- Binance有合約地址的是不是真正的幣

- 歐意app軟件下載

- OKX期貨合約的公允價值

- 火必huobi:邀請好友,免費獲得價值120元獎勵!

- huobi火幣火幣合約交易怎麽玩

- 歐意永續合約交易技巧

- OKX手續費返傭

- OK期貨主力合約

- 幣安中國開合約什麽意思

- 火必比特幣合約交易怎麽玩

- 特比特Tbit元宇宙就是騙局

- 歐意合約帝APP

- 幣安Binance什麽是合約產品

- 幣安Binance美國貨幣監理署前代理署長BrianBrooks將出任美國CEO

- OKEX合約上線永久返傭機製,交易返傭比率高達60%

- 歐易易歐app最新版v6

- 火必huobi虛擬幣合約怎麽玩

- KrpBit注冊沒有中國怎麽辦?注冊不了解決辦法

- 幣安中國國庫券合約價值

- 必客BKEX永續合約一年不平倉手續費多少錢

- WEEX一個智能合約包含什麽

- MEXC歐易交易所電腦版下載

- huobi火必期貨與長期合約的區別

- 歐易OKEX合作夥伴“永久返傭”招募計劃來啦~

- 歐易手續費最新對比,幣圈新人必看

- 歐易OKEX智能合約開發工程師

- KrpBitapp下載?手機app使用方法教程(買幣、交易

- 火幣huobi火網交易所app官方下載

- OKEX交易所的合約怎麽玩

- Binance期貨和合約的區別在哪

- 歐意合約機是什麽

- OKEX如何用代理買網比特幣

- 幣安Binance千億:Coinbase上市濾鏡後的巨獸

- MEXC合約交易

- MEXC虛擬幣125倍合約

- Tbit數字貨幣交易平台|網交易所|app下…

- 必客杠杆合約交易規則

- 歐易OKX交易所app最新版

- 歐易OKEXOK注冊返傭谘詢的微博

- 幣客BKEX怎麽提現人民幣?提現教程

- 特比特Tbit元宇宙NFT是騙局嗎

- huobi市佔第二NFT市場Blur正式發幣!免費空投代幣給用戶-Web3+

- 幣客非主力合約是什麽意思

- BKEX智能合約可以做什麽

- 特比特Tbitapp網址v1

- MEX58合約平台下載

- 幣客BKEX期貨和合約的區別

- 必客比特幣官網下載

- OKX合約方式是什麽意思啊

- MEXC期貨合約定義

- OK期貨裏最近合約是什麽意思

- 幣安Binance智能合約玩法

- 幣客BKEX永續合約和杠杆交易哪個好

- OKXokcoin合約交易規則

- Binance期貨合約的分類

- OK熱幣交易所下載官方app

- 火幣永續合約倍數計算方法

- BinanceKOL計劃指南

- huobi火幣注冊|官網|交易所app下載|官方網站

- huobiok合約賺了上千萬

- 火必永續合約賺錢技巧

- WEEXu本位合約賬戶是什麽意思

- 特比特Tbit中國大陸用戶注冊及邀請碼返傭教程

- 特比特騰訊元宇宙最新消息

- huobi合約是和交易所對賭嗎

- 火必huobi網APP漢化版

- 火必智能合約與決策

- 歐易OKEX為什麽玩合約最後都是輸

- OKEX返傭加碼不斷幣本位和U本位合約返傭均高

- 火必huobi合約返傭算法大揭秘,最高竟能返傭86%

- MEX撒錢盛宴後,Blur精心挑起新一輪版稅大戰

- 特比特期貨合約移倉最佳時間

- 幣客BKEX大使招募重磅開啟,來享高返傭

- 抹茶MEXCbfx合約平台

- MEXC大陸用戶如何使用|星雲財經

- 幣安中國合約的目的是什麽

- KrpBit合約125倍漲了2倍掙多少

- OKX永續合約保證金率多少合適

- huobi火必智能合約是一種需要人工

- Tbitbfx合約平台官網

- 特比特TbitNFT裏麵的美金怎麽出金tr的

- OKEX什麽是差價合約交易

- 唯客智能合約app有什麽功能

- 幣安何一合約真的能賺錢嗎

- 唯客比特幣合約做多怎麽交易

- 必客合約是什麽意思通俗解釋

- 歐意交易所app下載v4

- 特比特Tbit派是web3.0公鏈嗎

- 幣安何一合約交易怎麽賣出

- 幣安中國蘋果手機下載app全流程|應用市場|appstore|蘋果手機

- OK隊長超高返傭,帶你走上人生巔峰

- 幣安客戶服務中心的微博

- 抹茶MEXC期貨到期怎樣換合約

- 抹茶最強攻略:一文教你玩轉

- 唯客WEEX數字貨幣代理

- 火幣huobiapp下載app下載

- 歐易合約交易app

- 歐易OKX炒合約怎麽玩

- 幣客期貨與長期合約的區別

- TbitNFT交易平台網站

- MEX交易所app下載()

- BKEXic期貨合約是什麽

- 火必多米尼克元宇宙建國大業的背後,是重回三大的強烈信號

- 歐易OKX幣巴巴交易所app下載

- KrpBit合約真的能賺錢嗎

- 火幣huobi遠期合約的價值指什麽

- 火必合約返傭算法大揭秘,最高竟能返傭86%

- Tbit永續合約每天扣多少錢

- 特比特Tbit永續合約資金費太恐怖

- huobi火必新CEO尚未出爐正在重點引進符合要求的高級人才

- 幣安中國合約帝蘋果

- MEXC數字貨幣合約交易視頻教程

- 幣安何一區塊101丨VtradingCEO宋東來:普通人的財富密碼

- 必客BKEX【交易所教學】注冊3步開戶,極速入市

- 抹茶期貨合約的名稱應注明

- 火幣AICoin永續合約怎麽玩

- 必客BKEX差價合約平台中國有嗎

- OKX永續合約雙向開倉

- 特比特邀請碼在哪裏找永久20%返傭不能錯過

- 歐易OKX合約交易有哪些平台

- huobi期貨主力合約

- 火必huobi交易所注冊驗證?充值入金?充幣提幣?出金提現教程

- Tbit合約價值是什麽

- 幣安Binance國債期貨合約價值計算

- 特比特Tbit開合約什麽意思

- Tbit幣App下載

- 幣客BKEXok合約賺了上千萬

- WEEX開通永續合約交易答案

- 火必玩合約

- 幣安Binance期貨合約的交易單位

- BKEX永續合約交易平台排名

- BKEX數字貨幣合約交易合法嗎

- 歐意期貨主力合約有多少個

- MEX華為合約機是什麽意思

- 幣安何一千億:Coinbase上市濾鏡後的巨獸

- 歐易官方下載平台App

- 特比特web3怎麽投資

- 抹茶MEXC合約交易手續費怎麽算的

- huobi火必你的歐代靠譜嗎?如何貼標?一文揭秘歐代的水到底多深

- OKEX現在還有人做數字貨幣代理商嗎?

- 唯客股指期貨當季合約

- 幣安Binance永續合約會爆倉嗎

- WEEX永續合約資金費太恐怖

- 歐意商務合約是幹什麽的

- 幣客智能合約區塊鏈

- 火必區塊鏈合約交易是什麽

- 火必app下載|iOS|binance官網APP下載…

- 歐意DeFi趨勢:究竟什麽是鏈?智能鏈又是什麽?

- Binance什麽是智能合約有什麽優勢

- 必客遠期合約和期貨合約

- 歐易OKX怎樣注冊非大陸賬號|星雲財經

- 幣安何一揭秘比特幣全球第一大券商“”

- WEEXCEO涉嫌詐騙700萬人民幣?

- Tbitnft買賣平台

- 特比特Tbittr轉型nft另外七大陸

- 歐易OKEX官方下載|官方網站交易平台APP下載|數字資產

- MEX幣交易所app官網下載

- 幣安Binance創始人李林尋求出售股權退出中國損30%收入恐大裁員

- 幣安搭建ETHssl中轉操作教程和方法(包含抽水)實戰操作

- MEXC滬銀期貨合約規則

- MEX合約交易怎麽玩

- huobi永續合約一天大概手續費

- 特比特元宇宙教育應用案例

- OKXapp狗狗幣怎麽提現人民幣?app狗狗幣提現人民幣

- 抹茶MEXC交易所下載app最新官網下載

- 特比特Tbitweb3課程

- 唯客WEEX牛犇交易所APP下載

- 幣安中國必火十大創業項目你還想創業嗎?

- MEXC合約意識是什麽意思

- 必客BKEX哪個好|適合新手操作?

- huobi火幣期貨合約交易規則

- Binance停止中國大陸新用戶注冊,年底前清退存量用戶

- MEXC買入比特幣教程之篇

- 歐易OKEX永續合約的優劣

- MEXC交易所最新app下載官網

- 火幣huobi官方App下載|

- 抹茶杠杆合約交易規則

- 幣安Binance比特幣再次去中國化:、幣核等13家機構宣布退出大陸

- 必客ok交易所電腦下載

- 火必趙長鵬“玩火會自焚”嗎?幣圈風暴刮到了從FTX倒下的那一

- 必客BKEX節點計劃

- huobi期貨最短合約有多久

- MEXC貨幣|貴金屬|期貨現貨交易返傭最新資訊|柚子返傭網

- Tbit智能合約區塊鏈

- 火必智能合約三大要素

- KrpBit手機合約機是什麽意思

- 幣安中國Blur項目方明割韭菜,後續能否走的長遠?

- 火幣huobi華為合約機是什麽意思

- 火必huobi智能合約技術

- huobi火必交易挖礦是什麽?讓交易變簡單,再賺BNB50%手續費

- KrpBit全球站

- 幣客BKEX幣巴巴交易所app下載

- 必客監管重錘之下,加密貨幣交易所限製中國大陸內的交易

- OKEX回應決議解散境內主體:沒有繼續存續的必要,故申請注銷

- 幣安Binance期貨換合約有什麽影響

- MEXC移動合約手機是什麽意思

- Binance永續合約

- Tbit永續合約中途改杠杆

- 幣客BKEX交易所app最新版

- WEEX期貨合約與現貨合約

- 幣安何一CEO涉嫌詐騙700萬人民幣?

- Tbit國內關於nft的政策

- 幣安中國主力合約是什麽意思

- 幣客期貨合約規模怎麽算

- 幣安Binance智能合約開發工程師

- 歐易合約帝下載地址

- 抹茶MEXC永續合約規則

- 特比特TbitNo83.如何擼BlurNFT交易所第二賽季空投?手把手教程,注意這個細節提高擼空投效率

- 火幣huobi蘋果合約帝app最新

- WEEX:注冊實名認證,獲取價值高達3,000元的數字貨幣

- MEX購買合約機是什麽意思

- 特比特如何登錄web3

- 幣安Binanceu本位合約賬戶是什麽意思

- 幣安何一永續合約長期持有費用

- 特比特nft製作和交易

- 特比特Tbit差價合約共享交易

- MEXC京東移動合約機是什麽意思

- 特比特Tbit持倉合約價值怎麽計算